本文是一篇计算机论文,本文综合考虑数据和模型两个角度,提出了一个基于数据增强和模型微调的小样本学习框架DAMFT_FSL。该框架包括数据增强和模型微调两个模块,使用数据增强模块得到相关数据集,使用模型微调模块对数据增强带来的偏差进行调整。

第1章 绪论

1.1 研究背景与意义

1.1.1 研究背景

目前,大部分机器学习模型的有效性依赖于大量的数据,而在新药发现[1]、军事目标识别[2]、恶意流量检测[3]等实际领域,由于领域本身具有保密性、数据量少、数据获取成本高等特点,难以获取大量有效的数据。使用少量数据构建出性能良好的机器学习模型便于模型在各种实际应用场景的广泛使用。如何从小样本数据中挖掘更准确的信息,保证模型的泛化性能,是目前的研究热点之一。

小样本学习可以从数据、模型和优化算法三个角度进行研究。基于数据的小样本学习方法旨在通过增强数据集解决小样本问题,可分为样本级方法和特征级方法。样本级方法主要进行样本量的扩充;特征级方法主要通过特征选择、优化等方式减小需要的样本量。基于模型的小样本学习方法从模型设计的角度解决小样本问题,可分为模型微调、度量学习等方法。模型微调方法借助在相关领域学到的知识提高小样本学习的性能;度量学习方法通过为小样本数据学到合适的度量方式挖掘出更多有价值的信息。基于优化算法的小样本学习方法通过改进最优假设搜索方式增大找到最优假设的概率。目前,被广泛认可的适用于小样本学习的优化算法为元学习。元学习的核心是修改优化算法,使用多个任务训练一个元学习器,该元学习器旨在最小化所有任务的损失和,目的是让模型具有学习的能力,能够快速学习新任务。

对于小样本学习,基于数据的方法最直观,但可能引入噪声或偏差,基于模型的方法和基于优化算法的方法大多需要相关数据集的辅助。将基于数据的方法和其他两个角度的方法相结合可以同时解决偏差引入的问题和相关数据集获取的问题。因此,本文以小样本数据为研究对象,针对数据增强方法的偏差引入问题、模型微调方法的相关数据获取问题进行研究,综合考虑数据和模型两个角度,探索能将两类方法恰当结合的框架和算法,旨在在有限的样本上挖掘更准确的信息,得到性能良好的模型。

.....................

1.2 国内外研究综述

本文主要研究基于数据增强和基于模型微调的小样本学习方法,下文将介绍小样本学习的定义和核心问题,以及基于数据增强的小样本学习和基于模型微调的小样本学习的研究现状,并对小样本学习的发展趋势进行分析。

1.2.1 小样本学习定义与核心问题研究现状

(1)小样本学习的定义

2000年,小样本问题首次被关注到[4]。2003年,Li等人[5]注意到在少量样本上构建机器学习模型的重要性,并提出单样本学习(One-shot Learning)的概念,即在每类的带标签样本数为一个或几个的数据集上得到预测模型。鉴于在样本数过少的类上难以构建性能良好的模型,可以使用在其他类别上学好的模型进行辅助。随后的10年时间,通过少量样本进行学习的研究发展缓慢,直到2011年,Norbert等人[6]提出小样本学习(Few-shot Learning,FSL)的概念,小样本学习又叫少样本学习(Low-shot Learning),旨在从少量样本中学到解决问题的方法。

近年来,随着在大规模数据集上构建机器学习模型研究的深入,特定领域样本量小的问题日益凸显,小样本学习得到越来越多研究人员的关注。2020年,Wang等人[6]基于机器学习的定义给出了小样本学习的定义。针对某个任务,机器学习是从经验中学习到性能好的模型,一般情况下,经验是数据集。该文给出的小样本学习定义为:小样本学习是一个机器学习问题,它的特点在于经验中只包含有限的监督信息。同年,Lu等人[8]基于利用相关任务辅助学习的思想,给出了小样本学习的定义:给定一个只有少量监督信息的目标任务数据集和一个与目标任务相关的辅助数据集,小样本学习旨在为目标任务建立一个函数,该函数使用目标任务数据集中的少量有监督信息和辅助数据集中的知识将目标任务的输入映射到输出。

.......................

第2章 相关理论与方法

2.1 模型预训练和微调

2.1.1 模型预训练微调范式

模型预训练微调[56]是一种机器学习的基本范式,包括模型预训练和模型微调两个组成部分。第一部分在相关数据集上预训练模型得到参数,在预训练模型的基础上,第二部分使用目标任务的数据集进行模型再训练。由于需要进行模型的再训练,该范式只适用于可增量训练的模型。常用的增量学习模型包括神经网络模型、贝叶斯模型等,本文关注神经网络模型。对于该模型,模型预训练微调范式的结构图如图2.1所示。

计算机论文怎么写

图2.1中,X为目标任务的样本集,X’为与目标任务相关的数据集,????(????)表示参数为????的神经网络模型,????(????????)表示神经网络f的尾部,其参数为????????,ℎ(????ℎ)表示神经网络f的头部,其参数为????ℎ。

模型预训练时,使用相关数据集X’训练整个神经网络模型f得到参数θ。给定一个样本x,神经网络模型f的输出如公式(2.1)所示,通过神经网络的尾部????得到提取的特征????(????;????????),将该特征输入神经网络的头部ℎ得到整个模型的输出ℎ(????(????;????????);????ℎ)。

..........................

2.2 生成对抗网络

生成对抗网络[28]利用最大似然的思想和博弈论的对抗学习思想学习数据的分布,并生成新的数据。

2.2.1 生成对抗网络基本概念

生成对抗网络的结构如图2.2所示,包括生成模型G和判别模型D两部分,生成模型旨在学习数据的分布,判别模型旨在正确区分真实样本和生成样本。通过判别模型D和生成模型G的对抗训练可以学习数据集的分布,进而生成新样本。

目标函数如公式(2.28)所示。其中,????(????)为判别模型判定真实样本x为真实样本的概率,????(????(????))为判别模型判定生成样本????(????)为真实样本的概率。通过公式(2.28)可以看出,判别模型D旨在最大化生成数据和原始数据分布的距离,生成模型G旨在最小化生成数据集分布和原始数据集分布的最大距离。

最初的生成对抗网络存在一些问题,WGAN(Wasserstein Generative Adversarial Network)[64]从理论上对GAN进行研究,针对其存在的距离度量方式不能较好地训练模型、收敛速度慢、模式崩塌等问题给出了解决思路。WGAN的修改主要包括三方面:去掉sigmoid层、将JS距离换为Wasserstein距离和添加权重平滑约束。WGAN的目标函数如公式(2.31)所示,其中||????||????≤????表示判别模型D是K-Lipschitz函数。

............................

第3章 基于GAN和模型头部微调的小样本学习 ............................ 25

3.1 基于数据增强和模型微调的小样本学习框架 ............................27

3.2基于GAN和模型头部微调的小样本学习算法 ........................... 27

第4章 基于重参数GAN集成和MHLoss微调的小样本学习 .................... 46

4.1 基于重参数GAN集成和MHLoss微调的小样本学习架构 ....................... 46

4.2 基于重参数GAN集成和MHLoss微调的小样本学习算法 ....................... 48

第5章 总结与展望 ............................. 56

5.1 总结 .................................. 56

5.2 展望 ....................................... 56

第4章 基于重参数GAN集成和MHLoss微调的小样本学习

4.1 基于重参数GAN集成和MHLoss微调的小样本学习架构

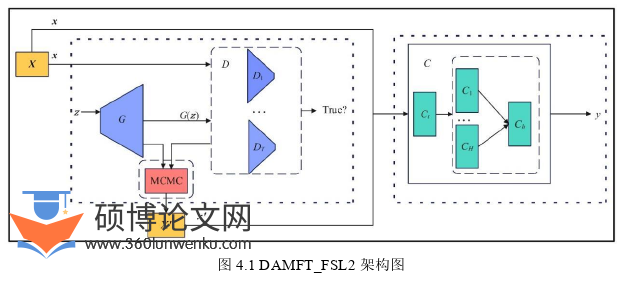

本章将在DAMFT_FSL框架下进行进一步研究,将重参数GAN集成方法引入数据增强模块,对生成模型和判别模型学到的分布进行纠偏,得到相关度更高的相关数据集;将增加迭代轮数和MHLoss策略引入模型微调模块,提高模型微调的稳定性,得到性能更好的分类模型。具体地,为生成对抗网络添加判别模型集成策略,在小样本数据集上得到训练好的生成模型和分布更加准确的判别模型;然后使用MCMC采样对生成模型学到的分布纠偏,得到相关数据集。在使用相关数据集预训练分类模型的基础上,通过增加迭代轮数和MHLoss策略微调分类模型。基于重参数GAN集成和MHLoss微调的小样本学习架构DAMFT_FSL2如图4.1所示。

计算机论文参考

...............................

第5章 总结与展望

5.1 总结

本文针对小样本问题,综合考虑数据和模型两个角度,提出了一个新的小样本学习框架,并在该框架下提出了两个小样本学习算法。

(1)针对数据增强方法存在的偏差引入问题,模型微调方法存在的相关数据集难以搜集的问题,本文综合考虑数据和模型两个角度,提出了一个基于数据增强和模型微调的小样本学习框架DAMFT_FSL。该框架包括数据增强和模型微调两个模块,使用数据增强模块得到相关数据集,使用模型微调模块对数据增强带来的偏差进行调整。

(2)针对使用模型微调方法解决小样本问题需要小样本领域的相关数据集的局限性,在DAMFT_FSL框架下提出了一个基于GAN和模型头部微调的小样本学习算法hGAN。该算法使用生成对抗网络为小样本数据集生成新样本,构造相关数据集,并在使用相关数据集预训练分类模型的基础上,使用模型头部微调策略对生成数据带来的偏差进行纠正。多个数据集上的结果表明,使用生成对抗网络构造的数据集与小样本数据集既相似又存在差异,可以作为相关数据集;相对于对比算法,本算法能够明显提高小样本分类的性能。

(3)针对在小样本数据上生成对抗网络的生成模型和判别模型学到的分布有偏差的问题,提出了一个基于重参数GAN集成和MHLoss微调的小样本学习算法MhERGAN。本算法使用重参数GAN方法对生成模型进行纠偏,使用判别模型集成策略对判别模型进行纠偏。此外,使用增加迭代轮数和MHLoss微调策略提高微调的稳定性,从而提高小样本分类的性能。实验结果表明,重参数GAN集成方法可以得到与小样本数据集相关度更高的相关数据集,且该小样本学习算法性能更好,更适合小样本分类。

参考文献(略)